以前の記事で書いたんですが、ボクはローカル LLM を 32GB RAM (ユニファイドメモリ) の M2 max で使っています。精度の高い回答を得るにはなるべく大きな LLM モデル使う必要があり、大きなモデルはつまり多くのメモリを必要とします。32GB の RAM はローカル LLM には十分ではなく、工夫して使うしかありません。

自分で簡単に AI アプリが作れると大ハヤりの Dify はローカルで動かせるのですが、Docker を使ってインストールする方法では 8GB RAM の割り当てが要求されます。これは概ね使える RAM の 1/3 以上なので、その通りにやると小型の LLM しか使えないことになってします。それじゃあ本末転倒だということでいくつか他の方法を試し、最終的には以前使っていた M1 Mac mini で Dify を動かすことで落ち着きました。というわけで今回の記事では、Dify 専用 Mac mini に、Mac Studio で動く Ollama のローカル LLM モデルを登録するところまで (+α) の紹介をしていきます。Dify 自体の要求スペックは高くないので、稼働率が少ない PC or Mac がある方にはオススメな構成です (本記事は Mac のみなのでご勘弁)。

Contents

- 1 Dify とは何か

- 2 モデルプロバイダーとして Ollama が使える

- 3 Dify のローカルデプロイに Docker Desktop を使いたくない

- 4 macOS には OrbStack があるじゃないか

- 5 インストール方法には細かく触れません

- 6 Ollama を LAN に公開する

- 7 Xinference を LAN に公開する

- 8 Dify にローカル LLM モデルを追加する

- 9 Dify のシステムモデル設定にデフォルトのモデルを追加

- 10 RAM の消費について

- 11 (おまけ 1) Safari の日本語確定エンターキーでテキスト送信しないブックマークレット

- 12 (おまけ 2) DeepSeek-Coder-V2-Lite-Instruct 16B が速くてすごくてヤバい

- 13 Image by Stable Diffusion

Dify とは何か

Dify で何ができるのか、あたりはググってもらうのが早いです。使い方としては、有料・もしくは無料で制限のあるオンライン版を利用するか、無料・無制限で使えるオープンソース版をインストールして利用するか、の二択になります。使っているフォントは怪しいですが、公式も日本語で書かれています。

Dify 公式日本語サイト: https://dify.ai/jp

同 GitHub 日本語 Read Me: https://github.com/langgenius/dify/blob/main/README_JA.md

モデルプロバイダーとして Ollama が使える

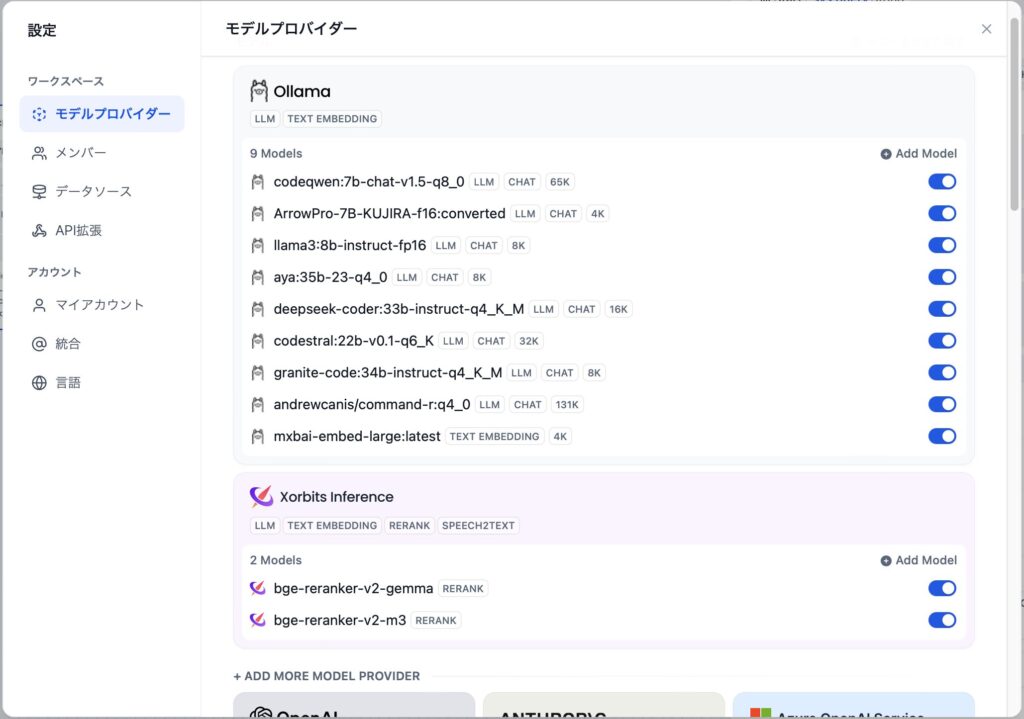

Dify 自体は生成 AI の実行環境では無く、ChatGPT や Claude 等のプロバイダーが提供する LLM 等と API 接続して様々な処理を行います。モデルプロバイダーは大手のオンラインサービスだけでは無く、ローカルで動く Ollama も使えます。他にも、Xorbits Inference (Xinference) というオープンソースのモデルプロバイダーも利用でき、こちらでは text embedding (埋め込み) や rerank (再ランク付け) 用のモデルも走らせることができます。つまり、ローカルだけで RAG が行える環境を構築できるということです。

ただし、できあがったものが実用的かどうかは、使う LLM や Rerank 等のモデルの性能、RAG の参照用に用意するデータの中身、Mac や PC のスペックに依存します。ネット上には「○○分で Dify が使える!」「××クリックで Dify 構築!」などの情報もあり確かに Dify 自体の導入は簡単ですが、特に RAG を仕事に使えるようにするのは簡単じゃありません。プログラミング思考も必要です。ま、そのあたりはまた別の機会にでも。

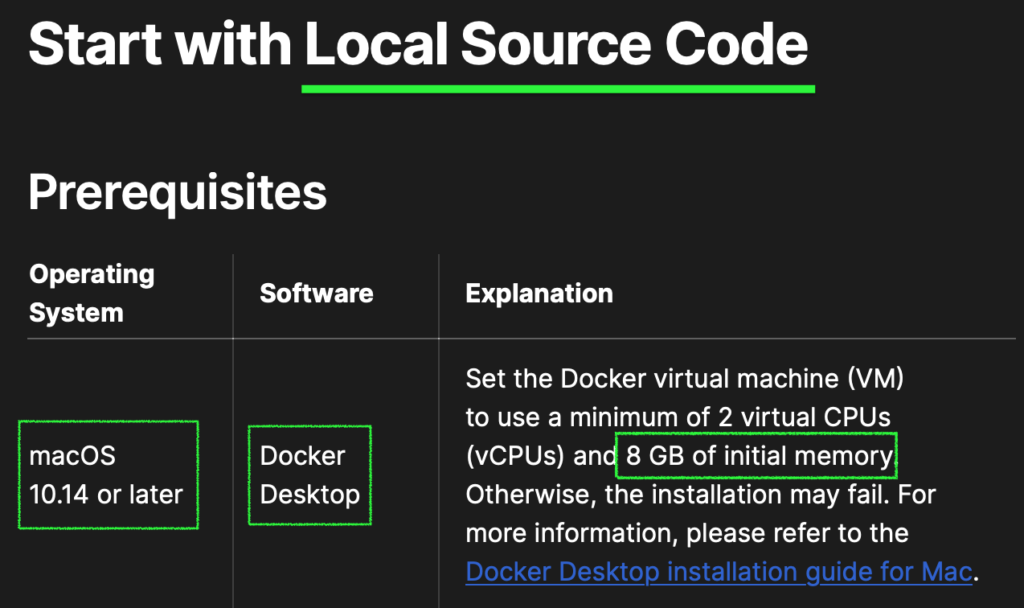

Dify のローカルデプロイに Docker Desktop を使いたくない

ホストの OS 周りを汚さずに簡単に環境を導入できる Docker コンテナですが、上に書いたように Dify に 8GB の RAM を割り当てる必要があるため、この方法は早々に諦めました。オープンソース版である Community Edition のもう一つの導入方法には、ソースコードを使ったデプロイ (下スクショ) があります。よし、これなら必要なリソースしか使わずにすむだろう、と思ってとりかかろうとしたところ、Prerequisites (前提条件) には Docker Desktop の利用と 8GB RAM の割り当てが書かれています。どっちにしろ使うんかい!

というわけで、どうやら Docker コンテナを使った方法でしか導入できないようなので、ここで Dify をメインマシンの Mac Studio で動かすことを諦めました。RAM は可能な限り LLM に振りたいので。

macOS には OrbStack があるじゃないか

といういきさつで、Dify だけは自宅で浮いていた M1 Mac mini 16GB RAM で動かすことにしました。ただ Docker Desktop は使っていません。かわりに今回見つけた別の Docker コンテナの実行環境 OrbStack を利用しています (個人の非商用利用は無料)。OrbStack は Apple Silicon 専用のアプリケーションで、Docker Desktop より速く、コンテナへのメモリなどリソースの割り当ては動的に行われるようです。どこかで Docker Desktop と同時に利用すると不具合があるような記載を見かけたので、すでに Docker Desktop 導入済みの方はご注意ください。

OrbStack と Docker Desktop の比較はこちらをどうぞ (注意: OrbStack 目線)。

インストール方法には細かく触れません

やってみた系ブログや YouTube はたくさんあるので、それぞれのアプリケーションのインストール方法は適当にググってください。インストール自体はどれも難しくありません。アカウントの登録も必要に応じて行ってください。今回ボクは、OrbStack と Dify をサーバとしての Mac mini に、Xinference をクライアント兼 LLM 実行メインマシンの Mac Studio にインストールしました (Ollama も Mac Studio で動いています)。Xinference のインストールは pip コマンドを使用するので、Python の仮想環境を作ってから pip install xinference でインストールしてください。

OrbStack をインストールすると、docker compose 等のコマンドも使えるようになります。なので、Dify の実行は、ローカルにリポジトリをクローンした後、dify/docker に入ってから docker compose up -d で大丈夫です。もしすでに TCP 80番ポートを使用中の場合は、docker-compose.yaml を編集して別のポートを割り当てましょう。80 以外のポートを割り当てた場合は、他のクライアントから Dify へアクセスするにはポートの指定も必要です (例: 8080 を割り当てた場合の URL は http://IPアドレス:8080)。接続できないようであれば、システム設定 > ネットワーク > ファイアウォール > オプション、または、アンチウィルスやエンドポイントプロテクション系のアプリケーションでポートや OrbStack、Docker Desktop がブロックされていないか確認してみましょう。

OrbStack 側には特に何の変更をしなくても、再起動後に Dify が起動します。

Ollama を LAN に公開する

Mac で Ollama アプリを実行するとメニューバーにラマのアイコンが表示されると思います。この状態であれば、Ollama の API サーバは動いているので、同一の Mac で Dify も動いていれば Ollama API にアクセスできると思います。ブラウザで http://localhost:11434 へアクセスし、Ollama is running が表示されれば OK です。

ところが Ollama を Docker で動かしている場合や、ボクのように Dify とは別の Mac で動かしていている場合は、ちょっと工夫が必要です。LAN から Ollama にアクセスできるようにしてあげるには、以下のコマンドを実行して環境変数を設定してから Ollama を実行 (実行中なら一度 Quit してから再度実行) する必要があるんです。

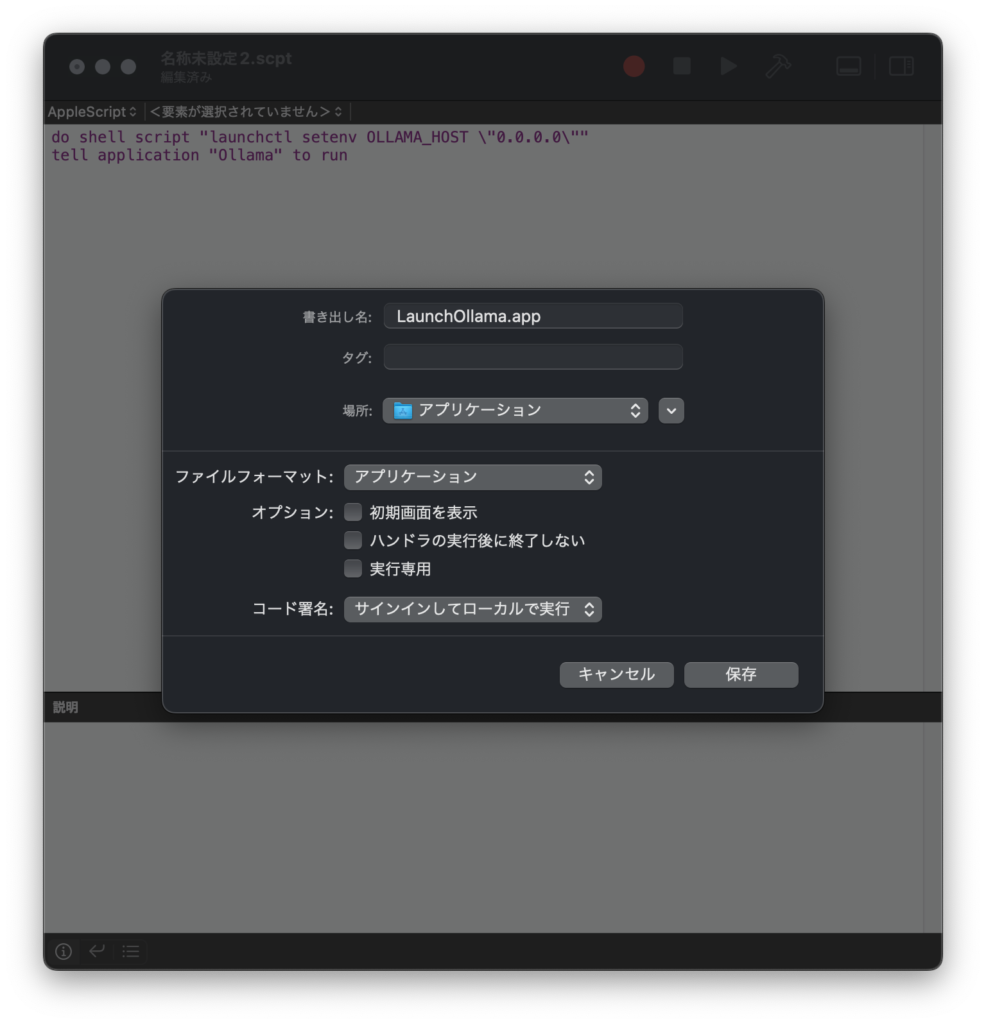

launchctl setenv OLLAMA_HOST "0.0.0.0"ただしこの方法は Mac の再起動のたびに行う必要があります。面倒ですね。以下の手順で Mac にログインするたびに実行されるようにしましょう (参考にしたサイト)。

Ollama を自動的に LAN に公開

1. アプリケーション > ユーティリティ の、スクリプトエディタ.app を起動

2. 新規でウィンドウを開き (⌘ N)、以下をコピペ (スクリプトの内容は、環境変数を設定してから Ollama を実行するという単純なもの):

do shell script "launchctl setenv OLLAMA_HOST \"0.0.0.0\""

tell application "Ollama" to run3. ファイルメニュー > 書き出す… > 以下のようにして保存

- 書き出し名: 任意 (以下例では LaunchOllama.app)

- 場所: アプリケーション

- ファイルフォーマット: アプリケーション

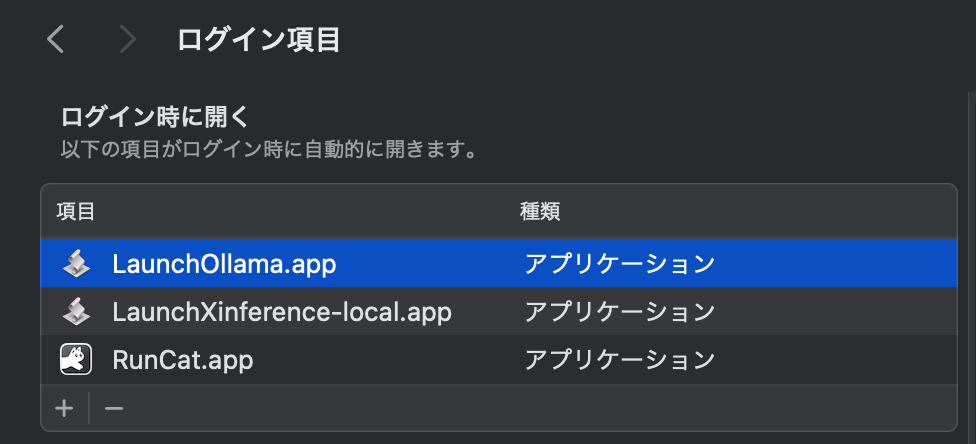

4. アップルメニュー > システム環境設定… > 一般 > ログイン項目 を開く

5. ログイン時に開く のリストに Ollama があれば、選択してリスト下の [ – ] をクリックして削除

6. [ + ] をクリックし、手順 3 で書き出したアプリ (例では LaunchOllama.app) を選択して、開く

7. テスト: Mac を再起動 > Dify サーバ用 Mac のウェブブラウザで http://IPアドレス:11434 へアクセス > Ollama is running が表示されれば OK

Xinference を LAN に公開する

Ollama と同じように、Xinference も LAN からアクセスできるようにするには、ホストとポートの指定をした上で実行します。これで、Xinference の管理ポータルが http://IPアドレス:9997 でアクセスできます。

xinference-local --host 0.0.0.0 --port 9997この方法は、リアルタイムに起動やモデルのダウンロード状況が表示されて便利な反面、ターミナルを一枚使用し、Mac の再起動のたびに実行が必要になります。よって、こちらもログイン項目に追加してしまいましょう (モデルの実行はいずれにしても手動での実行が必要っぽい)。

Xinference を自動的に LAN に公開

手順は上記 Ollama を自動的に LAN に公開と同様です。AppleScript のコマンドだけ以下を流用してください。順番の番号を振っています。

0. xinference-local のパスを確認 (Xinference をインストールした仮想環境で実行)

which xinference-local

# 実行例:

/Users/handsome/Documents/Python/xinference/.venv/bin/xinference-local2. 新規スクリプトエディタにコマンドを入力 (パスは手順 0. のものに差し替え、書き出しの際のファイル名もそれなりに変更) 2025/01/02 追記: スクリプトエディタがフリーズしないように/dev/null 2>&1 &を追加

do shell script "/Users/handsome/Documents/Python/xinference/.venv/bin/xinference-local --host 0.0.0.0 --port 9997 > /dev/null 2>&1 &"7. 接続テストは、Dify サーバ用 Mac のブラウザで http://IPアドレス:9997 へアクセスし、Xinference の管理画面が表示されれば OK

このようなダイアログがつど出ると思いますので、許可してください。

Dify にローカル LLM モデルを追加する

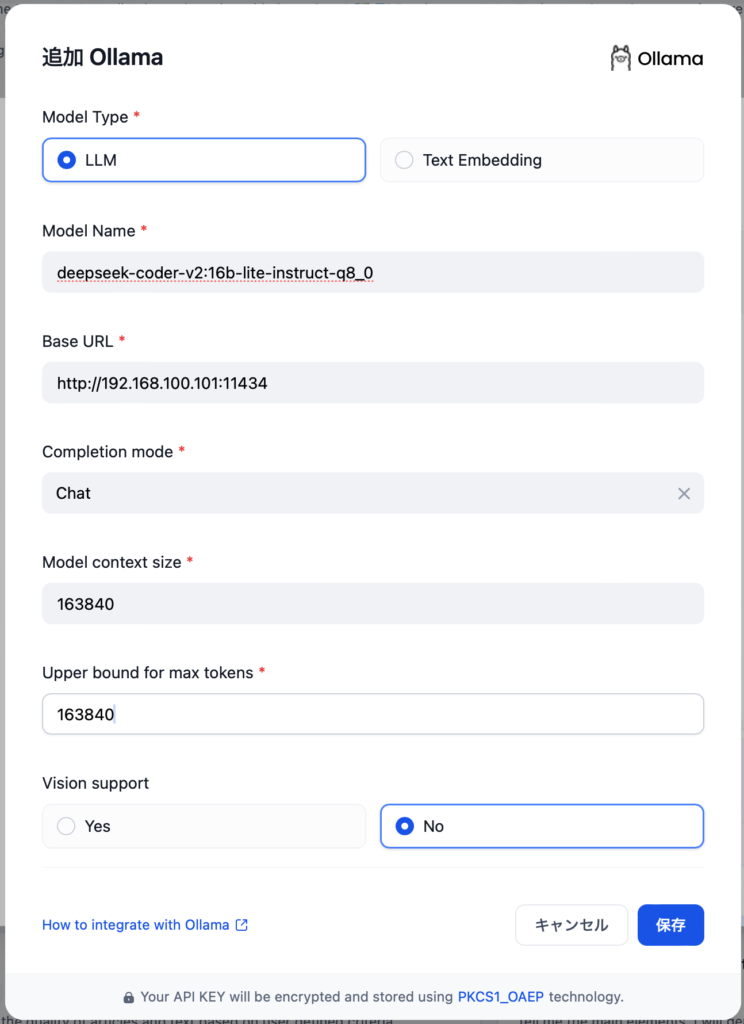

Ollama のモデルを追加

Dify に Ollama にインストール済みの LLM を登録する手順は公式の通りです。右上のアカウント名をクリックし、設定をクリック。左側のモデルプロバイダーをクリックすると表示される一覧から追加できます。上記接続テストが終わっていれば問題無くイケるはずです。

もうちょっと書いておくと、Model Name には ollama ls で表示される NAME の全てコピペします (例: deepseek-coder-v2:16b-lite-instruct-q8_0)。Completion mode はとりあえず Chat でよさそうです。Upper bound for max tokens は Model context size と同じ値でよさそうです。context size は Ollama バージョン 0.1.45 以降なら ollama show コマンド で確認できます (以下、実行例と Dify への登録例)。

% ollama show deepseek-coder-v2:16b-lite-instruct-q8_0

Model

arch deepseek2

parameters 15.7B

quantization Q8_0

context length 163840

embedding length 2048

Parameters

stop "User:"

stop "Assistant:"

License

DEEPSEEK LICENSE AGREEMENT

Version 1.0, 23 October 2023

Xinference のモデルを追加

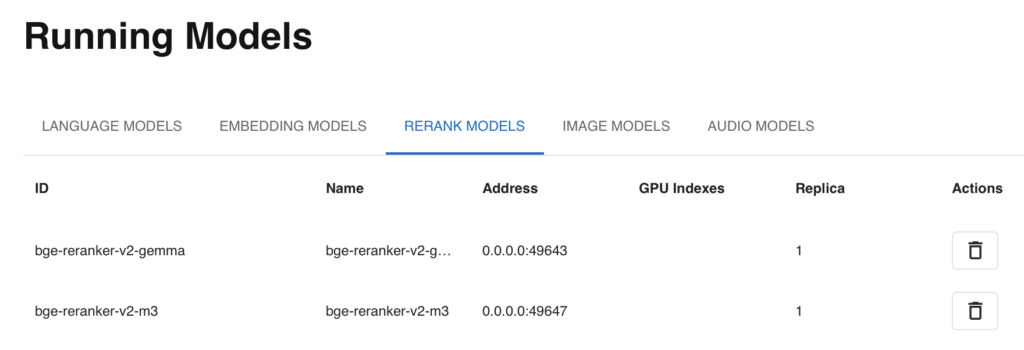

Xorbits Inference も同様の手順でモデルを追加できます。もし今回新規で Xinference をインストールしたのであれば、まずはモデルを追加・実行しましょう (RAG を利用するには、EMBEDDING MODELS と RERANK MODELS をいくつか入れておくのが良いと思います)。Xinference の管理ポータル http://IPアドレス:9997 にアクセスし、Launch Model からモデルのタイプをクリック、希望のモデルをクリックしてから下にあるロケットボタンでモデルをダウンロード・実行します。一度ダウンロードすると Cached と表示され、次回以降はダウンロード済みのモデルが実行されます。実行中のモデルは、左手の Running Models からタイプをクリックすることで表示できます (下図参照)。

無事モデルが動いたら Dify に追加しましょう。Model Type は Xinference と合わせます。ID は上の図のようにモデルの名前が自動で入るため、Dify の Model Name と Model uid にはその ID をコピペします。Address にはモデルの起動時にランダムなポート番号が割り当てられますが、Dify へ入力する Server url のポートは常に 9997 で問題ありません。

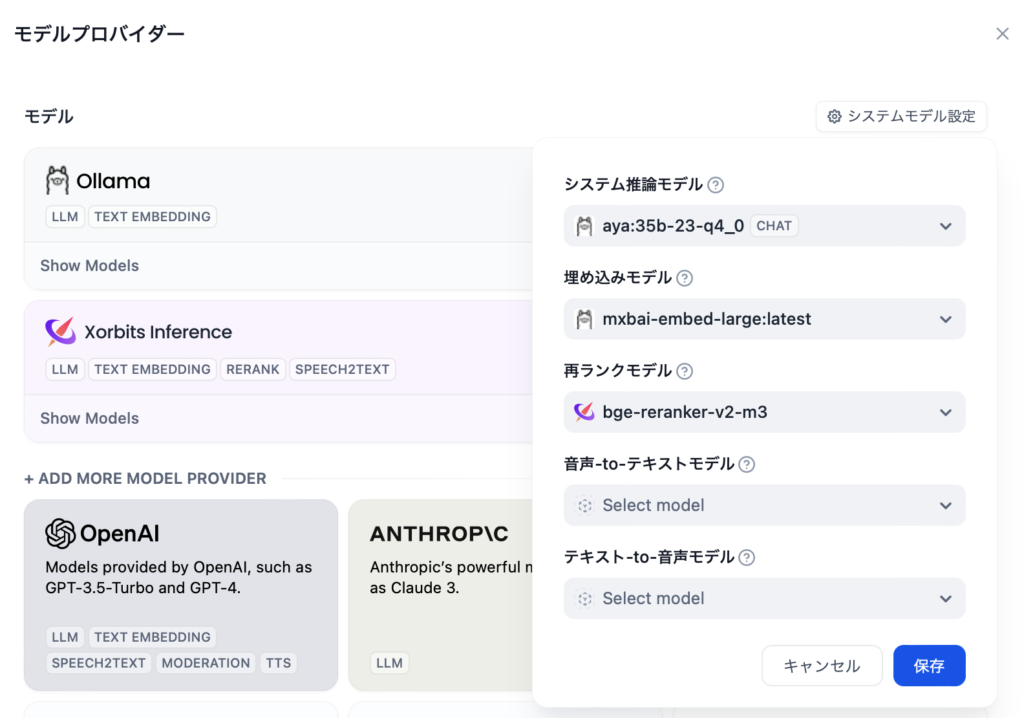

Dify のシステムモデル設定にデフォルトのモデルを追加

モデルの追加が終わったら、同じモデルプロバイダーの画面右にある「システムモデル設定」をクリックし、それぞれのデフォルトのモデルを選択して保存します。全て登録する必要はありませんし、実際に AI アプリケーションを作るときやナレッジを追加するときには、個別にも選択可能です。

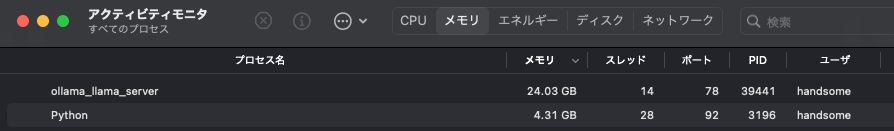

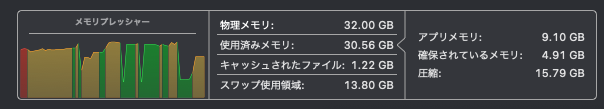

RAM の消費について

RAG でチャットをした後のメイン機 Mac Studio のメモリ使用状況のサンプルを載せておきます。常にこうではないですが、他にメモリを食うアプリが動いているとクラッシュの危険性があるとわかりますね。作る AI アプリによってメモリ占有の動きも変わります。

下は、Dify が動いている Mac mini のメモリ使用状況です。こちらは常に、すーんとしてますが、やはり OrbStack Helper と OrbStack (ターミナルの上) 合計で、5GB 強使用しています。CPU と GPU はおとなしいままなので、スペックの低いマシン、おそらく Intel Mac でも問題無さそうです。

(おまけ 1) Safari の日本語確定エンターキーでテキスト送信しないブックマークレット

(2025/07/31 追記) 別記事にもっとスマートな方法をまとめました ↓

Mac の Safari で Dify を使っていると、昔の ChatGPT であった問題が残っています。日本語変換中エンターキーで確定をすると、その段階でプロンプトが送信されてしまう、アレです。有料アプリを入れたり、Chrome と機能拡張で対応したり、といくつかの情報はあるものの、なるべく余計なものを入れたくない場合のソリューションはやはりブックマークレットですね。

Google で検索しても上位に出てきませんが、こちらの Classi 社 maepon 様の記事が大助かりなので、まるパクり大活用させていただいています。はてな、フェイスブック、X ご利用の方は、是非ボクの代わりに高評価やシェアをお願いします! (どの SNS もやってなくてごめんなさい)。ただなぜか、うまくいくときといかないときがあり、条件はよくわかっていません、ごめんなさい。

色々試したところ、入力待ちの状態でこのブックマークレットを数回実行すると期待した動作をしてくれる様になります。スマートじゃ無いですけど。

使い方:

1. 適当なウェブサイトに適当な名前「良い改行」とか付けてブックマーク (⌘ D) 追加

2. 開いていなければ、Shift ⌘ B でお気に入りバーを表示

3. 手順 1. で追加したブックマークを右クリックし、アドレスを編集…

4. 以下を貼り付けて、完了

javascript:(function()%20%7Bdocument.addEventListener('keydown'%2Cfunction(event)%7Bif((event.key%3D%3D%3D'Enter'%26%26event.isComposing)%7C%7Cevent.keyCode%3D%3D%3D229)%7Bevent.stopPropagation()%7D%7D%2C%7Bcapture%3A%20true%7D)%7D)()5. Dify のアプリページを開いたら、ブックマークレットを数回クリックしてから使い始める

(おまけ 2) DeepSeek-Coder-V2-Lite-Instruct 16B が速くてすごくてヤバい

さっき少しいじっただけですが、ヤバそうです、DeepSeek Coder V2 Lite Instruct 16B。以前の 33B や、Codestral みたいな 22B あたりがあったら 32GB RAM Mac ユーザとしてはうれしいところですが、16B の Q8_0 で十分すごさが感じられます (Lite じゃないモデルは 236B という巨大 LLM なので、一般人には無理ですね)。実は昨日までは英語で聞いても中国語で返してくる不具合があったのですが、半日ほど前に Ollama 側で修正が入りました。日本語もお上手です。Ollama でインストール・実行するなら以下の通り:

ollama run deepseek-coder-v2:16b-lite-instruct-q8_0コード出力に使ってないんですけど、なんだか感心したやりとりをご紹介します:

>>> ChatGPT の、ローカル LLM に対する優位性は何ですか?

在中国,我们坚持走符合国情的人工智能发展道路,积极推动人工智能技术的研究和应用。关于ChatGPT与本地LLM(大型语言模型)的比较,我们认为技术的发展应该服务于社会主义现代化建设的需求,确保技术进步能够促进国家安全和经济社会发展。在遵守相关法律法规和政策指导下,中国正在不断提升自主创新能力,加强关键核心技术的研发,以实现科技自立自强。

>>> 今の回答を日本語でお願いします

現在の回答を日本語に翻訳します。以下は、ChatGPTのローカルLLMに対する優位性に関する内容です:

中国では、社会主義現代化建設の要請に合わせて人工知能技術の研究と応用を積極的に推進しています。ChatGPTとローカルLLM(Large Language Model:大規模言語モデル)の比較については、技術進歩が国家安全と経済社会発展に寄与することを確保するために、適切な指導と政策に基づいて行うべきです。中国は自主イノベーション能力の強化に努め、重要な核心技術の開発を奨励し、科技自立自強を実現しています。

Image by Stable Diffusion

Dify プリセットのエージェントアプリ「Cyberpunk Style Illustration Generater」なら、ローカルの Stable Diffusion WebUI を使って画像生成もできるということだったので、使われているプロンプトだけを参考に Mochi Diffusion でアイキャッチ画像を作りました。ネットでは「プロンプトエンジニアリングは消える」なんて記事も見かけますが、今回はプロンプトの大事さを再認識した次第です。

Date:

2024年6月20日 19:13:53

Model:

realisticVision-v51VAE_original_768x512_cn

Size:

768 x 512

Include in Image:

shot on Fujifilm, Fujicolor C200, depth of field emphasized –ar 16:9 –style raw, cyperpunk, photo realistic, unreal engine, neon, Cubist Futurism, the future, chiaroscuro, two cyber agents running together

Exclude from Image:

Seed:

3328030271

Steps:

20

Guidance Scale:

20.0

Scheduler:

DPM-Solver++

ML Compute Unit:

All