なーんだ、そうなのか。という感じですよね。以前の記事で触れた X への投稿みたいな、「そろそろ MLX 対応するぜ」的匂わせなのか、全く関係ないのか。とりあえずいじってみたのでまとめました。

情報元は v0.9.1 のリリース

オフィシャルの GitHub リポジトリの該当リリースがこちらです:

https://github.com/ollama/ollama/releases/tag/v0.9.1

New Ollama for macOS and Windows preview

という見出しと共に、Download for macOS というリンクと、追加された設定機能のスクリーンショットが見つけられます。

2025年6月22日追記: すでに Version 0.9.2 の preview も出ていますね。ダウンロードは Release ページの Asset にある Ollama-Preview.dmg をクリック:

https://github.com/ollama/ollama/releases

macOS 向け Preview バージョンのハイライト

Preview の特徴をざっくりまとめるこういうことのようです (というか、現状これくらいの情報しかみあたらない):

- Settings で、LAN やインターネットへ (簡単に) 公開する事ができるようになった (環境変数

OLLAMA_HOSTと同じ?) - Settings で、ローカルのブラウザからのアクセスを有効にできるようになった (Ollama JavaScript Libraryを使う人には便利らしい? Open WebUI みたいなフロントエンドかと思ったらそうではなかった)

- Settings で、モデルの保存場所を (簡単に) 変更できるようになった (環境変数

OLLAMA_MODELSと同じ?) - macOS ネイティブアプリとなり、インストールに必要なサイズがかなり小さくなり、起動も速くなった (え?今まではネイティブアプリじゃ無かったの?)

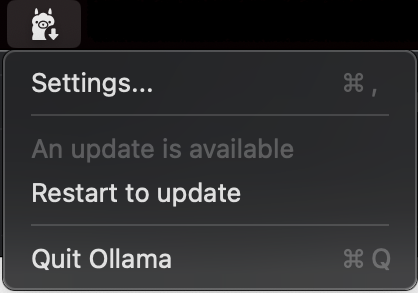

- Preview をアップデートすると通常の最新バージョンになってしまう (Restart to update すると、それはもう Preview では無くなってしまう、ということなので注意)

Settings ウィンドウはメニューバーのアイコンから開く事ができ、設定の保存は [ Update Settings] ボタンです。

使ってみてどうか

どうなんですかね?Qwen3:32b と QwQ:32b を使ったチャットするだけアプリを Dify で作って速度を見てみましたが、LLM の動作に何か良い影響があった感じではありませんでした。ま、この部分は MLX 対応されてからのお楽しみでしょうね。最近動きが見えないですけど。

Settings でいじれる内容についても、個人的にはメリット無いです。下の別記事に書いていますが、ボクは macOS のログイン時に Ollama サーバが LAN に公開されるようにしているので起動も速くなったかどうかわかりません。外付けの SSD にモデルの保存先を変更するなら起動スクリプトにOLLAMA_MODELSを追加すれば良いし、今回の Preview バージョンによる恩恵は見つかっていません。追加情報や Preview のアップデートに期待、というところです。

というわけで、他に掘り下げる情報も見つからないので、今回はここまで。

Image by Stable Diffusion (Mochi Diffusion)

単純に「実験室のラマの赤ちゃん」をいくつか描いてもらいました。ビーカーをのぞき込む感じがプレビュー/レビューと重なったので、こちらを採用

Date:

2025年6月20日 19:41:28

Model:

realisticVision-v51VAE_original_768x512_cn

Size:

768 x 512

Include in Image:

a baby lama in a scientific lab

Exclude from Image:

Seed:

3804362856

Steps:

21

Guidance Scale:

20.0

Scheduler:

DPM-Solver++

ML Compute Unit:

CPU & GPU